从推荐您需要在购物网站上购买的东西,以便在社交网络上成为朋友,人工智能(AI)已成为我们生活中的指导力量。

然而,这项技术的重要性也使人们意识到已经成为其中的一部分的偏差,提高了技术公司的压力来弥补。

例如,谷歌现已建立了一个外部咨询委员会,以帮助科技巨头以道德和负责任的方式发展AI技术。

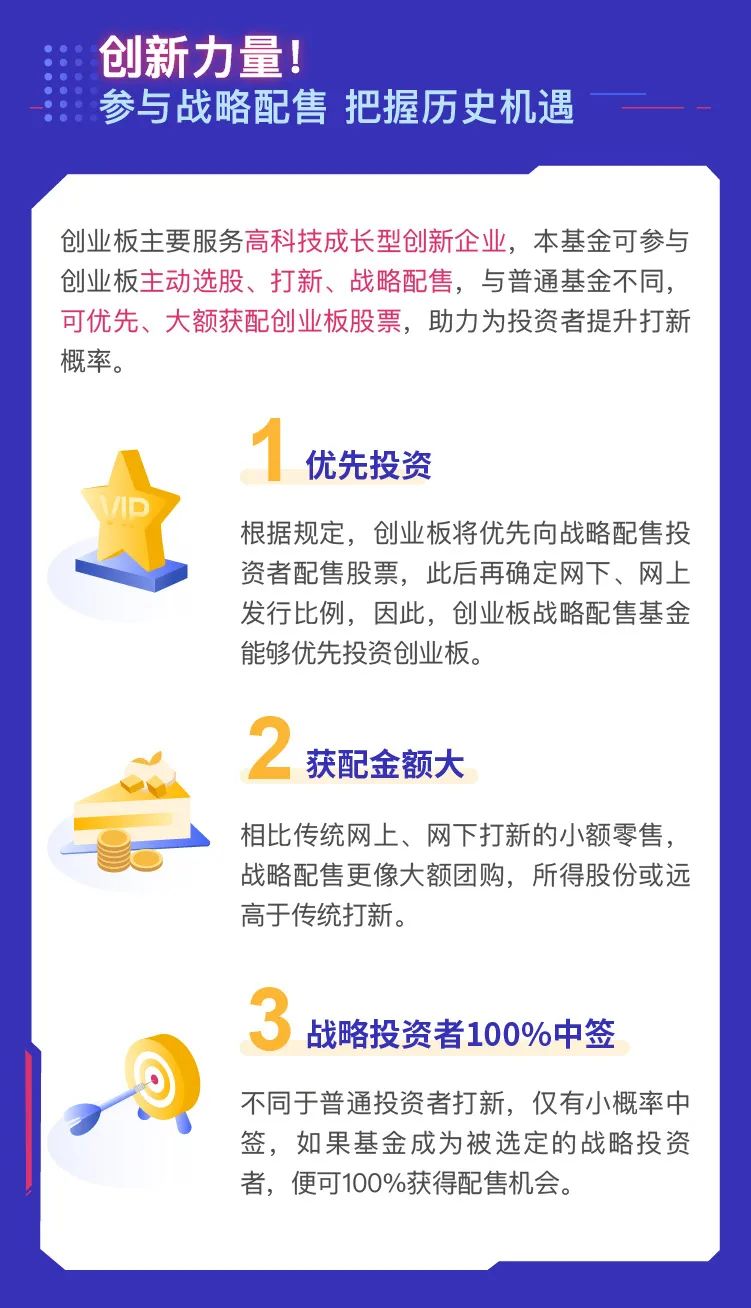

电子商务巨头亚马逊本月宣布,它与国家科学基金会(NSF)合作,在未来三年内筹集了高达1000万美元,专注于AI公平的公平。

“我们相信我们必须与学术研究人员密切合作,开发创新的解决方案,以解决公平,透明度和问责制的问题,并确保自然副总统Natarajan Prem Natarajan的Data Don”T的数据中的偏差在亚马逊的Alexa Ai集团在博客帖子中写道。

偏见的自动化工具可以将弱势群体进一步推到边距。例如,想象一下,考虑妇女不太智能的AI招聘工具。如果作业门户雇用这样的工具,则更有可能向雇员推荐雄性计划雇用新人的组织。

我们在我们的设备上拥有的AI助手呢?如果谷歌助理,SIRI,或者对于那件事alexa,以女性的声音谈论,它可以让我们的孩子相信女性 - 不是男人 - 应该是助理。

根据调查新闻网站Propublica的一份报告,在美国法院客房常用的一个风险评估工具被发现推荐对白人的惩罚比黑人。

因此,使AI无偏见成为人类自由至关重要,并确保所有和战斗歧视的平等机会。但为什么AI工具显示偏见并反映我们社会中已存在的偏见?

这部分是因为构建AI的社区没有充分反映世界的普及。根据2018年世界经济论坛报告称,全球只有22%的AI专业人士是女性。

“如果AI系统仅由所有男性,所有亚洲人或所有高加索人建造的一个代表性组;那么他们更有可能创造偏见的结果,”Mythreyee Ganapathy,Director,Programe Management,Cloud和Enterprise,Microsoft告诉IANS。

“将用于培训AI模型的数据集需要由Perse组数据工程师组装。一个简单的例子是用于训练语音AI模型的数据集,主要针对成人语音样本无意中排除儿童,因此模型无法识别儿童的声音,“她指出。

使AI不一定可能不会最终使世界各地展出展会,但这可能是朝着偏见和创造平等机会的重要一步。